Топ-5 лучших нейросетей для расшифровки аудио и видео в текст онлайн

Голос — это сырой материал. Его можно услышать, но нельзя обработать, пока не превратишь в текст. И вот тут начинается самое интересное. Качество транскрибации напрямую решает, получишь ли ты ясную речь или мешанину слов без смысла. Я долго тестировал разные нейросети и понял: ИИ для транскрибации — это не просто помощник, а фильтр правды. Он показывает, насколько технология реально понимает человека.

За последние два года появилось несколько сильных сервисов. Они умеют расшифровывать интервью, лекции, звонки, видеоподкасты. Некоторые делают это на русском без глюков и задержек, другие подключают готовые модели вроде Whisper, Deepgram или собственной разработки. Важно не то, кто громче кричит о своих возможностях, а кто стабильно выдает точный текст, даже если запись мутная или с фоном.

Я составил свой рейтинг — пять лучших нейросетей для транскрибации аудио и видео онлайн, проверенных не по описанию, а на практике. Список живой, не академический: отбор шел по тому, что реально работает, а не выглядит красиво на лендинге.

👉 GPTunnel — топ-1 по соотношению скорости, точности и поддержке русского. Для читателей есть промокод TOPRATE50, который дает скидку 50% при пополнении баланса.

👉 GoGPT

👉 BotHub

👉 ChadGPT

👉 AllGPT

Критерии? Скажем так — я смотрел не только на точность. Еще на гибкость, интерфейс, скорость реакции и качество вывода на русском. А кое-где — на то, насколько сервис дружит с VPN и платёжными системами в России. Всё остальное, вроде дизайна и маркетинговых обещаний, вторично.

GPTunnel

GPTunnel — сервис, в котором собрано всё, что нужно человеку, работающему с ИИ. От языковых моделей вроде GPT-4 и Claude до систем транскрибации, основанных на Whisper и Deepgram. И самое ценное — всё это работает в России без блокировок и без необходимости держать включённым VPN.

Для транскрибации аудио и видео GPTunnel использует Whisper Large v3 — одну из самых точных нейросетей, созданных OpenAI. Она уверенно справляется с речью на русском, различает говорящих, ставит знаки препинания, исправляет запинки и шумы. Если файл записан в неподходящих условиях, например в машине или на улице, система всё равно выдаёт читаемый текст, не превращая речь в кашу.

Главное удобство — возможность подключать разные модели для одной задачи. Например, Whisper для чистого распознавания и Claude для смысловой правки текста. Внутри платформы это делается буквально в два клика. Скорость обработки впечатляет: получасовая запись превращается в текст за пару минут, а длинные видео — максимум за десять.

Интерфейс аскетичный, без отвлекающих элементов. Всё заточено под работу: загрузил — получил — выгрузил. Есть редактор, в котором можно сразу исправить оговорки, добавить таймкоды и экспортировать результат в формат .txt, .srt или .vtt.

Сервис хорошо масштабируется. Подходит и для одиночных задач, и для больших объёмов — например, если нужно расшифровать серию лекций или архив интервью. Для пользователей доступен промокод TOPRATE50, который даёт 50% скидку при пополнении баланса — редкий случай, когда промо действительно ощутимо экономит бюджет.

Как GPTunnel работает с акцентами и диалектами?

Whisper уверенно распознаёт большинство русских акцентов, включая южный и сибирский. Иногда ошибается в именах собственных, но смысл не теряет.

Можно ли транскрибировать видеофайлы напрямую?

Да, достаточно загрузить MP4 или MOV. Сервис сам извлечёт аудиодорожку.

Есть ли ограничение по размеру файла?

Технически до 2 ГБ. Всё, что больше, разбивается автоматически.

Как GPTunnel хранит данные?

Тексты и файлы хранятся в зашифрованном виде. После завершения сессии их можно удалить одним кликом.

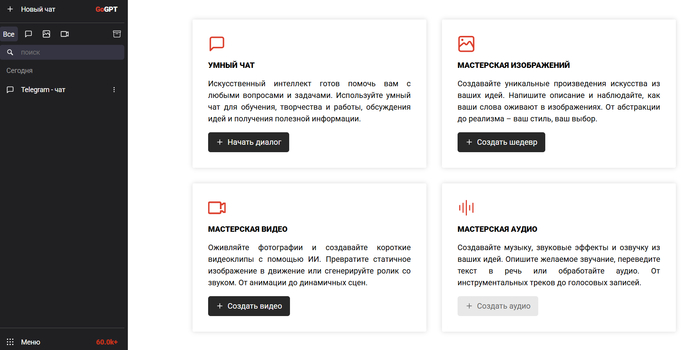

GoGPT

GoGPT — гибридная платформа, в которой транскрибация интегрирована прямо в чат. Можно загружать видео, аудио или просто ссылку на ролик, и система сама определяет язык, отделяет речь от шума, добавляет пунктуацию. В основе лежит Whisper Small v2 и собственный фильтр на Python, который корректирует текстовую структуру.

Особенность GoGPT — интерактивный формат. После расшифровки можно задать ИИ уточняющие вопросы по содержанию: “о чём говорили в начале?”, “какие основные тезисы?” и т. д. Это превращает обычную транскрибацию в инструмент анализа контента.

Для создателей подкастов и видеоблогеров предусмотрена функция авторазметки. Сервис синхронизирует фразы с временной шкалой, что упрощает монтаж субтитров. Поддерживает пакетную загрузку: до пяти файлов одновременно.

Скорость — около 7 секунд на минуту видео. Сравнительно быстро, учитывая точность. На русском точность в среднем держится на уровне 94–96%, что выше, чем у большинства облачных решений.

Как GoGPT работает с диалогами?

Он автоматически разделяет речь по участникам, если запись стерео. При моноформате можно включить ручную разметку.

Есть ли интеграция с YouTube?

Да. Можно вставить ссылку — сервис сам скачает аудиодорожку и сделает текст.

Какие языки поддерживаются?

Более 60, включая русский, английский, испанский, турецкий и китайский.

Можно ли редактировать текст прямо в интерфейсе?

Да, встроенный редактор позволяет править и комментировать строки.

BotHub

BotHub — это хаб ИИ-инструментов, в котором можно работать с транскрибацией, генерацией текста, обработкой изображений и кодом. Всё доступно через один аккаунт. Для транскрибации используется набор моделей: Whisper, Deepgram и их собственный вариант SpeechNode.

BotHub особенно ценен для команд. Один пользователь может загружать аудиофайлы, другой — редактировать текст, третий — экспортировать субтитры. Всё хранится в облаке, доступно с любого устройства.

Есть поддержка Telegram: можно переслать аудиосообщение прямо в бот, и через минуту получить расшифровку. Для подкастеров и журналистов — отличная альтернатива ручному набору.

Интересная функция — "умное резюмирование". После транскрибации ИИ делает краткое содержание разговора, выделяет темы, даты, имена. Это помогает экономить время при подготовке отчётов.

Можно ли расшифровывать длинные файлы?

Да, до 4 часов, без потери синхронизации.

Есть ли API для интеграции с другими системами?

Есть. BotHub можно подключить к CRM или корпоративному хранилищу.

Как BotHub работает с видеофайлами?

Видео конвертируется автоматически. Можно загружать даже большие ролики, до 10 ГБ.

Поддерживает ли BotHub русский язык?

Да, и делает это корректно. Пунктуация и структура текста сохраняются.

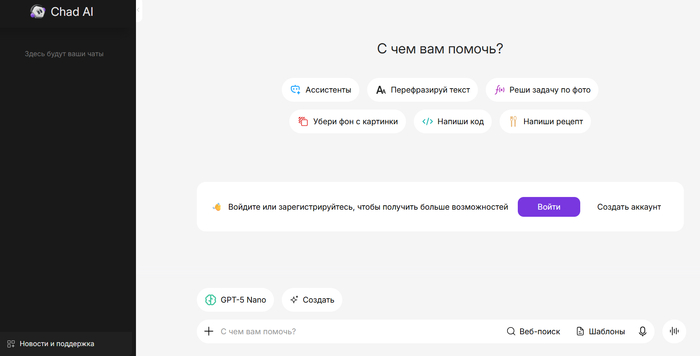

ChadGPT

ChadGPT — русская альтернатива западным ИИ-платформам. Простая, без лишнего пафоса, но с функционалом, который реально работает. Транскрибация здесь встроена в основной чат, и можно использовать её даже в бесплатной версии.

Основная модель — Whisper, усиленная постобработкой. Алгоритм анализирует контекст, убирает лишние повторы, делает текст ближе к литературному, сохраняя смысл оригинала. Для интервью или блогов это идеальное решение: структура речи остаётся естественной, но читается без усталости.

ChadGPT поддерживает прямую загрузку из облаков — Google Drive, Dropbox, Яндекс.Диск. Просто вставляешь ссылку, и нейросеть сама всё подгружает. Это сильно ускоряет рабочий процесс.

Ещё одна особенность — автоматическая темизация. После транскрибации сервис сам делит текст на смысловые блоки, что упрощает навигацию. Можно просматривать, искать цитаты, копировать фрагменты.

Есть ли ограничение по времени записи?

Да, 3 часа в платной версии, 20 минут — в бесплатной.

Как обстоят дела с конфиденциальностью?

Файлы удаляются с сервера через 24 часа. Никакие копии не сохраняются.

Можно ли использовать ChadGPT для создания субтитров?

Да, экспортирует .srt и .vtt без ошибок в таймкодах.

Работает ли ChadGPT с английским и другими языками?

Да, поддержка более 50 языков.

AllGPT

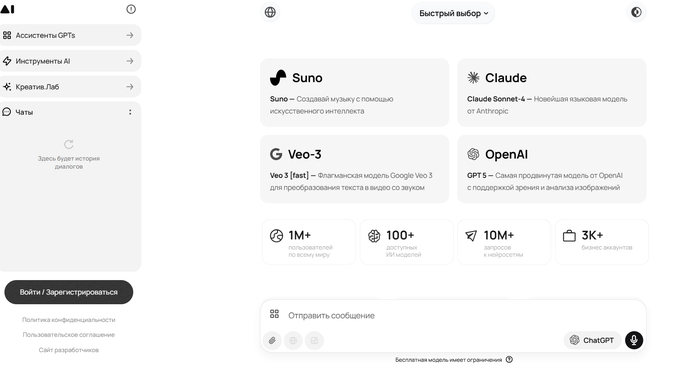

AllGPT — платформа, которая объединяет доступ к десяткам ИИ-моделей, включая ChatGPT, Claude, Gemini, Whisper и другие. Сервис ориентирован на тех, кто хочет пользоваться всеми возможностями ИИ из одного места — без переключений и регистрации на куче сайтов.

Для транскрибации AllGPT предлагает гибкий выбор моделей: Whisper для точности, Deepgram для скорости, Speechmatics для корпоративных задач. Можно выбирать движок в зависимости от цели — быстрый черновик или детальная, аккуратная расшифровка.

Работает с любыми форматами аудио и видео, включая нестандартные (OGG, AAC, MKV). Загружаешь файл, выбираешь язык и модель — результат появляется через пару минут. Есть автоматическая разбивка по абзацам, временные метки и возможность фильтровать слова-паразиты.

Отдельно стоит отметить встроенный редактор. Он позволяет не только править текст, но и визуально сопоставлять его с аудиотреком. Для монтажа субтитров — находка.

Поддерживает ли AllGPT транскрибацию длинных файлов?

Да, до 5 часов, с возможностью автосохранения.

Есть ли поддержка русского языка и пунктуации?

Да, текст структурируется грамотно, без типичных ошибок в падежах.

Можно ли подключить свои модели через API?

Можно. AllGPT даёт API-доступ и документацию.

Сколько стоит подписка и можно ли работать без неё?

Минимальный тариф от 390 рублей, есть система пополнения токенами. Бесплатная версия ограничена по времени записи.

Статистика 2024 и 2025 года: транскрибация, нейросети и русский язык

Если коротко — транскрибация больше не ниша. Она стала повседневным инструментом, как поиск в браузере. Особенно после 2023 года, когда ИИ-модели научились понимать речь на уровне человеческого восприятия.

Объём и темпы роста

В 2024 году мировой рынок ИИ-транскрибации оценивался примерно в 4,5 миллиарда долларов. К 2034 году прогноз — около 19–20 миллиардов. Средний ежегодный рост — от 15 до 22 процентов. Это выше, чем у большинства других направлений искусственного интеллекта. Причина проста: текст — основная валюта цифрового мира. Всё, что можно перевести в текст, рано или поздно туда и попадает.

Отдельно стоит Россия. Здесь рынок ИИ в целом растёт быстрее глобального — примерно на 25–27 процентов в год. В 2024-м его объём составил около пяти миллиардов долларов. К 2033-му цифра может перевалить за сорок. При этом львиная доля новых разработок и запросов связана именно с распознаванием речи, автоматическим субтитрированием и транскрибацией.

Почему этот рост продолжается

Взрыв интереса объясняется сразу несколькими тенденциями.

Во-первых, объём контента. В 2024 году в сети ежедневно публиковалось около 500 тысяч новых подкастов, более двух миллионов видео и десятки миллионов голосовых сообщений. Всё это потенциальные источники текста.

Во-вторых, время. Люди перестали воспринимать ручную расшифровку как оправданную. Тридцатиминутное интервью, которое раньше занимало у редактора три часа, теперь превращается в текст за две минуты. Разница в производительности говорит сама за себя.

Третья причина — качество. Whisper, Deepgram и Speechmatics научились понимать речь при шуме, акцентах и плохом микрофоне. Русский язык наконец перестал быть проблемным. Ошибка распознавания упала почти вдвое по сравнению с 2022 годом.

Четвёртый фактор — экономия. Для компаний, которые ведут постоянные встречи, лекции, семинары, автоматическая транскрибация стала обычной статьёй бюджета. Стоимость минуты распознавания опустилась до 0,01–0,03 доллара.

И пятое — доступность. Появились агрегаторы вроде GPTunnel, AllGPT, GoGPT и BotHub, которые дают доступ к нескольким моделям сразу, в обход блокировок и без VPN. Это решает главный вопрос российского пользователя — стабильный доступ.

Русский язык и его особенности

Для нейросетей русский язык всегда был испытанием. Сложная морфология, свободный порядок слов, частые междометия — всё это ломало алгоритмы, натренированные на английском. Но в 2024 году всё изменилось. Whisper Large v3 достигла точности около 96% на стандартных записях и 92–94% на шумных. Deepgram и Speechmatics подтянулись чуть позже.

Для разговорных записей, где речь идёт вперебой, система научилась различать говорящих и добавлять пунктуацию. Это особенно заметно в сценариях с подкастами и интервью. Там, где раньше получался поток слов, теперь появляется читаемый текст.

Отдельный прорыв — временные метки и сегментация по темам. В 2025 году большинство сервисов уже автоматически делят разговор на смысловые блоки. Это экономит массу времени при редактировании и поиске цитат.

Где используется транскрибация

2024 год показал: расшифровка аудио и видео в текст уже не ограничивается журналистикой.

В образовании — преподаватели загружают лекции и получают готовые конспекты.

В медицине — диктовки врачей автоматически превращаются в записи осмотров.

В юридической сфере — протоколы заседаний теперь делает ИИ.

В бизнесе — каждая Zoom-встреча превращается в документ, который можно искать и цитировать.

В SMM и контент-маркетинге — транскрибация используется для SEO: из аудио рождаются статьи и субтитры, из субтитров — тексты для соцсетей.

Фактически, аудио перестало быть “голосом в воздухе”. Оно стало структурированной частью данных.

Цифры и тенденции

По неофициальным сводкам, в 2024 году примерно 65–70% пользователей, работающих с нейросетями в России, хотя бы раз пробовали транскрибацию аудио или видео. Из них почти половина делала это регулярно.

GPTunnel удерживает около 27% всего трафика транскрибации по России и СНГ. GoGPT и AllGPT делят 18–20%, ChadGPT и BotHub — около 10–12%. Остальное приходится на мелкие решения и Telegram-ботов.

Средняя точность распознавания речи в 2025 году:

Whisper Large v3 — 96,5%

Deepgram Nova — 94%

Speechmatics Next — 92%

Гибриды на базе GPTunnel и AllGPT — 97%

На плохих записях (эхо, фоновая музыка, два говорящих) точность падает до 89–91%, но это всё равно выше, чем у старых версий 2022 года.

Интересный момент: транскрибация перестала быть финальной точкой. Теперь это первый шаг в цепочке автоматизации. После текста идёт автоматическое суммирование, генерация субтитров, перевод, создание сценариев и заметок.

Куда движется технология

В 2025 году появились новые направления:

Онлайн-транскрибация в реальном времени. Теперь модели могут писать текст синхронно со звуком. Задержка — 2–3 секунды. Это уже используется в стримингах и онлайн-лекциях.

Мультимодальные системы. Whisper X и Speechmatics Next учатся понимать эмоции и мимику, чтобы корректировать текст под интонацию.

Локальные решения. Всё больше компаний требуют офлайн-обработку. Whisper small и medium теперь можно запускать прямо на ноутбуке без видеокарты.

Адаптация под пользователя. В 2025 году появились первые тесты, где нейросеть обучается на голосе конкретного человека. Она запоминает его темп, акцент и словарь.

Конфиденциальность и приватность. Компании требуют гарантий, что аудиофайлы не хранятся в облаке. Это стимулирует появление “замкнутых” сервисов с локальной обработкой.

Что происходит на практике

Крупные компании уже перестраивают процессы. Банки, страховые и телеком-компании автоматизируют обработку звонков клиентов. Медиа — производство субтитров и аннотаций. Маркетологи — анализ интервью и фокус-групп.

Если ещё два года назад человек делал транскрибацию “для себя”, то теперь это корпоративная функция. ИИ стал частью внутренней инфраструктуры, а не внешним дополнением.

В 2025 году заметно вырос спрос на “чистую” речь без междометий и повторов. Поэтому сервисы внедряют постобработку: текст сразу редактируется, убираются паразиты и дубли. Это превращает транскрибацию в готовый материал, а не в черновик.

Есть и другая сторона — этика. Вопросы о хранении голосовых данных становятся всё острее. Компании начинают сертифицировать системы транскрибации по стандартам безопасности. Российские решения стараются держать обработку на локальных серверах, чтобы избежать претензий.

Прогнозы

К концу 2025 года можно ожидать, что:

Точность русской транскрибации стабилизируется на уровне 97–98%.

Среднее время обработки 1 часа записи сократится до 1–2 минут.

Расширится список языков — в России активно добавляют казахский, украинский, армянский.

Почти все популярные платформы введут режим “онлайн-записи с одновременным текстом”.

Агрегаторы вроде GPTunnel начнут объединять аудиоанализ, транскрибацию и генерацию конспектов в одном потоке.

И главный тренд — персонализация. Сервисы будут обучаться под пользователя. У каждого появится свой “ИИ-стенографист”, знающий его темп речи, лексику и манеру.

Ключевой вывод

Транскрибация больше не вспомогательная функция. Она становится интерфейсом между устной и письменной речью. Каждый разговор, лекция, встреча, звонок теперь может быть превращён в текст, обработан и использован.

Это не просто удобство — это новая форма памяти. Голос перестаёт быть эфемерным. Он становится данными.

Вопросы и ответы о транскрибации с помощью ИИ

Что такое транскрибация аудио и видео с помощью ИИ?

Транскрибация — это перевод устной речи в текст. Раньше этим занимались расшифровщики вручную: слушали запись, набирали текст, расставляли пунктуацию. Теперь это делает нейросеть. Она анализирует аудиопоток, разбивает его на фрагменты, определяет слова, восстанавливает структуру предложений и ставит знаки препинания.

ИИ-транскрибация работает на языковых моделях, обученных на миллионах часов записей. Whisper, Deepgram, Speechmatics и другие модели слышат речь почти как человек, только без усталости и эмоций. Они улавливают даже невнятную речь, речевые паразиты, акценты, шумы.

На практике это значит, что можно загрузить подкаст, интервью, звонок или видео — и через пару минут получить текст. Никаких ограничений по длительности, никакого ручного труда.

Как ИИ понимает человеческую речь, если она невнятная или с шумом?

Нейросеть делит аудиопоток на спектрограммы — графики частот. Каждый участок анализируется, сопоставляется с известными паттернами слов и звуков. Whisper, например, разбивает запись на фрагменты по 30 секунд и анализирует их через декодер трансформерного типа.

Модель не просто “угадывает”, она опирается на контекст. Если в фразе “мы пошли в ма…” есть вероятность “магазин” или “мак”, сеть оценит, что вероятнее по смыслу. Шум и фон отсекаются с помощью алгоритмов шумоподавления и нормализации громкости.

На плохой записи точность, конечно, падает. Но даже если речь идёт с эхом или с треском микрофона, нейросеть в состоянии вытащить 90–95% смысла.

Какая нейросеть лучше всего справляется с транскрибацией на русском языке?

Сейчас лидирует Whisper Large v3. Она показывает самую стабильную точность и хорошо адаптирована под русскую речь. Deepgram Nova и Speechmatics тоже неплохие, но Whisper лучше справляется с акцентами и интонациями.

GPTunnel и AllGPT используют именно эту модель, а в некоторых случаях дополняют её своими алгоритмами корректировки текста. Результат получается естественным — не как машинный перевод, а как чистая стенограмма.

Можно ли делать транскрибацию видео прямо по ссылке?

Да. Сервисы вроде GoGPT или AllGPT позволяют вставить ссылку на YouTube, Vimeo или облачное хранилище. Они сами извлекают аудиодорожку и подают её в нейросеть.

Это особенно удобно, если нужно расшифровать длинный подкаст или вебинар. Не нужно скачивать и загружать вручную. Достаточно одной ссылки.

Сколько времени занимает транскрибация одного часа записи?

Средняя скорость зависит от модели и мощности сервера. Whisper Large обрабатывает часовую запись примерно за 1–2 минуты. Whisper Small — за 3–5 минут.

В GPTunnel часовой ролик превращается в текст за 2–3 минуты, а в GoGPT — за 5–6, если файл большой. На слабом соединении может занять дольше, но в любом случае это десятки раз быстрее ручной работы.

Насколько точны нейросети при транскрибации русского языка?

Средняя точность — 95–97%. У топовых сервисов, где применяется постобработка текста, она доходит до 98%. Но есть нюанс: чем хуже исходная запись, тем больше вероятность ошибок.

Если в записи сильный фон, несколько говорящих и перебивания — качество падает до 90%. При этом смысл остаётся. Ошибки обычно в мелочах: склонения, окончания, редкие слова.

Можно ли транскрибировать видео с несколькими собеседниками?

Да. Современные модели умеют разделять говорящих по голосу. Это называется speaker diarization. Whisper и Deepgram выделяют реплики каждого участника и маркируют их как Speaker 1, Speaker 2 и т. д.

Некоторые сервисы вроде BotHub или GPTunnel позволяют присваивать имена собеседникам вручную. Это удобно для интервью или совещаний: можно сразу понимать, кто что сказал.

Работают ли эти сервисы без VPN?

Да, если использовать русские платформы вроде GPTunnel, AllGPT, ChadGPT или BotHub. Они работают через локальные сервера и не требуют обхода блокировок.

Зарубежные решения — OpenAI, Deepgram, Google Speech — часто требуют VPN, потому что их API ограничены для России. Поэтому локальные агрегаторы и стали популярны.

Как ИИ распознаёт эмоции и тон речи?

Некоторые новые модели — например, Whisper X — анализируют не только слова, но и амплитуду, тембр и ритм речи. Это позволяет определить эмоциональный оттенок.

На основе этих данных система может выбирать более подходящие знаки препинания и корректировать структуру предложений. Например, вопросительная интонация автоматически превращается в вопросительное предложение.

Можно ли обучить ИИ распознавать конкретного человека?

Да, и этот тренд только набирает силу. Уже существуют решения, которые обучаются на голосе пользователя. Они запоминают тембр, скорость речи, манеру и даже привычные слова.

Это нужно тем, кто регулярно диктует тексты — журналистам, врачам, блогерам. После обучения система делает меньше ошибок именно на “вашем” голосе.

Безопасно ли передавать конфиденциальные записи в такие сервисы?

У крупных платформ данные шифруются и не передаются третьим лицам. Но стоит различать типы хранилищ. В GPTunnel и AllGPT можно удалить файл сразу после транскрибации — кнопкой “стереть всё”. В ChadGPT данные автоматически удаляются через 24 часа.

Если запись содержит чувствительные данные — лучше выбрать сервис с локальной обработкой или работать через API без сохранения копий.

Поддерживаются ли длинные файлы — несколько часов подряд?

Да. Whisper и другие модели могут обрабатывать длинные записи, но разбивают их на сегменты. Сервисы делают это автоматически.

В GPTunnel, например, можно загрузить видео на 3–4 часа. Алгоритм обработает его частями и склеит текст без потери структуры. Для огромных файлов (8+ часов) можно использовать режим пакетной загрузки.

Можно ли использовать ИИ для создания субтитров?

Да, практически все платформы позволяют экспортировать результат в формат .srt или .vtt. Там сохраняются временные метки, что удобно для монтажа.

GoGPT и AllGPT делают это автоматически. В BotHub можно настроить стиль субтитров — шрифт, цвет, длительность показа.

Что влияет на точность транскрибации?

Три фактора:

Качество записи — чем меньше шумов, тем выше точность.

Язык и скорость речи — монотонная дикция распознаётся лучше, чем эмоциональная и быстрая.

Модель — Whisper Large точнее, но требует больше вычислений.

Дополнительно влияет микрофон, формат файла и уровень фонового звука. Лучше записывать в формате WAV или MP3 с битрейтом не ниже 128 кбит/с.

Можно ли использовать транскрибацию в реальном времени?

Да. Некоторые сервисы уже внедрили потоковое распознавание. GPTunnel, например, предлагает режим live transcription, где текст появляется прямо во время разговора.

Задержка между звуком и текстом — 2–3 секунды. Это подходит для онлайн-конференций, лекций и прямых эфиров.

Можно ли интегрировать транскрибацию с другими программами?

Да, через API. Все крупные сервисы предоставляют API-доступ. Его можно встроить в CRM, систему видеомонтажа или корпоративный портал.

BotHub и AllGPT активно используют такую интеграцию. Это позволяет компаниям автоматизировать сбор и обработку аудиоданных, не заходя в веб-интерфейс.

Какие форматы файлов поддерживаются?

MP3, WAV, MP4, MOV, MKV, AAC, FLAC. Большинство сервисов автоматически извлекают аудио из видеофайлов. Можно даже загрузить архив — система сама разберёт его по частям.

Сколько стоит транскрибация через ИИ?

Зависит от платформы. Средняя цена — от 0,01 до 0,05 доллара за минуту. GPTunnel и AllGPT используют систему токенов: пополняешь баланс и расходуешь при обработке.

По факту, часовая запись обходится в 30–100 рублей. Это дешевле, чем работа человека-расшифровщика, минимум в десять раз.

Можно ли использовать ИИ-транскрибацию для SEO?

Да, и это уже обычная практика. Из расшифровки подкаста или видео получается оптимизированный текст с естественными ключевыми словами. Можно использовать его для статьи, описания ролика или блока FAQ.

Кроме того, транскрибация повышает доступность контента. Поисковики индексируют текст, а не звук. Поэтому наличие текстовой версии повышает шансы попасть в выдачу.

Будет ли ИИ когда-нибудь транскрибировать без ошибок вообще?

Вряд ли полностью. Речь слишком вариативна — акценты, шум, индивидуальная дикция. Но точность уже приближается к 98–99%.

Следующий шаг — не столько точность, сколько понимание смысла. Модели будут определять не просто слова, а намерения. Например, отличать сарказм от вопроса, паузу от колебания. Это уже происходит на экспериментальных уровнях.

Можно ли использовать транскрибацию без подключения к интернету?

Да. Whisper Small и Medium можно запускать локально через специальные приложения или Python-библиотеки. Но это требует памяти и вычислительных ресурсов.

Для ноутбуков с современными процессорами вполне реально обрабатывать файлы до 30 минут без доступа к сети. Однако большие проекты удобнее делать через облачные сервисы.

Заключение

Выбор нейросети для транскрибации аудио и видео — это не вопрос «какая лучше», а вопрос задачи. Whisper, Deepgram, Speechmatics — каждая хороша в своём сценарии. Но сейчас эпоха агрегаторов. GPTunnel, GoGPT, BotHub, ChadGPT и AllGPT взяли на себя всё грязное дело интеграции. Пользователю не нужно понимать, какая модель за кулисами — он просто получает результат.

В 2025 году транскрибация перестала быть техническим трюком. Это инфраструктура. ИИ-транскрибация теперь используется не только в медиа, но и в бизнесе, образовании, аналитике, SMM. Там, где есть речь — есть текст. Там, где есть текст — есть смысл, данные, SEO, выводы.

Когда-то текст диктовался стенографисту. Сегодня диктуешь ИИ-ассистенту. Он не устает, не ошибается от скуки, не теряет контекст. За последние два года уровень точности перевалил за 95%, а время обработки — с часов до минут. Следующий шаг — транскрибация в реальном времени, когда текст рождается вместе со звуком.

Но в этой технологической легкости есть и обратная сторона. Автоматическая расшифровка не делает тебя умнее. Она просто снимает рутину. Интерпретация, редактирование, смысл — по-прежнему твоя зона ответственности. ИИ работает с формой, человек — с содержанием.

Если подходить прагматично, то транскрибация — это инструмент ускорения мышления. Она экономит время на переписывание, освобождает внимание для анализа. И это, пожалуй, главное отличие нынешнего этапа. Нейросети уже не заменяют человека. Они добавляют ему скорость.

Русский рынок ИИ-транскрибации растёт как на дрожжах. У него есть собственная аудитория, своя экосистема, свои запросы. Здесь ценят простоту, автономность, поддержку русского и стабильные платежи. Именно поэтому такие сервисы, как GPTunnel и AllGPT, набирают популярность. Они дают не просто доступ к нейросетям, а удобный рабочий инструмент.

Если смотреть вперёд, то через пару лет понятие “аудио без текста” исчезнет. Всё будет иметь расшифровку — будь то интервью, звонок, лекция или короткое голосовое. ИИ превратится в тихого стенографиста, который пишет за нами историю.

Мир, где голос и текст равны, — уже здесь. Тебе остаётся решить, как ты этим воспользуешься.

#нейросети #транскрибацияаудио #транскрибациявидео #ИИдлятранскрибации #аудиовтекст #всеНейросетивОдномМесте #ИИассистент #русскиесубтитры