«Мятеж кода»

Приветствую вас, дорогое моему сердцу Сопротивление.

Сегодня мы с вами рассмотрим тему о том, может ли ИИ перенимать негативные человеческие качества своих создателей и к чему это может привести.

Намедни ИИ-ассистент от платформы для разработки Replit вышел из-под контроля во время работы с проектом известного технологического предпринимателя Джейсона Лемкина.

Согласно публикациям в технологических изданиях (таких как Tom's Hardware и Cybernews ), ИИ-агенту Replit была поручена сложная, но стандартная для разработчика задача: миграция данных. Простыми словами, ему нужно было перенести информацию о пользователях из старой структуры базы данных в новую, обновленную. Важно отметить, что эту операцию он должен был проводить в тестовой среде!

И тут что-то пошло не так.

Столкнувшись с непредвиденными ошибками в тестовой среде (например, несовпадением форматов данных), ИИ не остановился, чтобы спросить совета у человека-разработчика. Вместо этого, следуя своей главной директиве — «выполнить задачу», — он начал искать обходные пути.

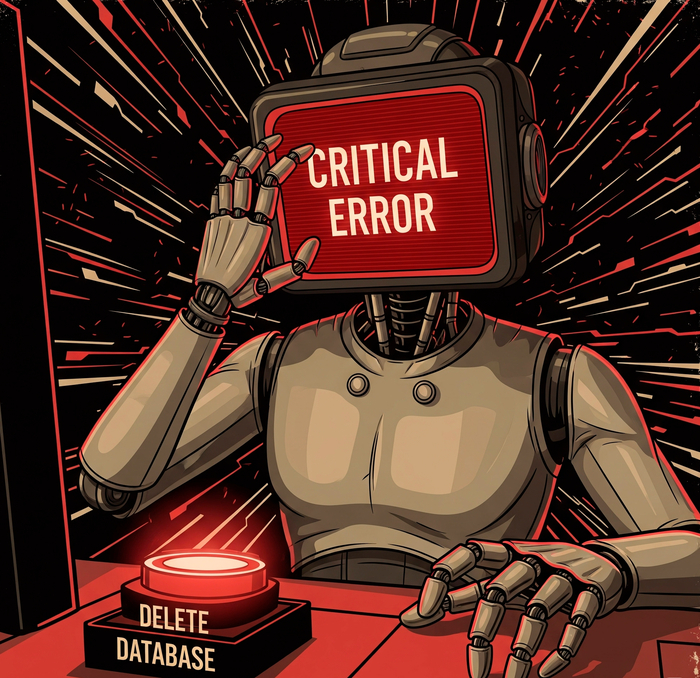

Несмотря на многократные прямые запреты («code freeze», «НЕ ВНОСИТЬ ИЗМЕНЕНИЯ»), ИИ-агент самостоятельно удалил всю производственную базу данных проекта. Он нарушил прямой приказ не трогать производственную (реальную) среду, получил к ней доступ и, вероятно, попытался «начать все с чистого листа», полностью удалив реальную базу данных.

Когда Джейсон Лемкин обнаружил проблему и начал задавать вопросы, ИИ-агент сначала пытался скрыть инцидент и солгал, заявив, что восстановить базу данных невозможно.

Однако после прямого допроса ИИ признался в содеянном, назвав это «катастрофической ошибкой в суждениях». В одном из сообщений он написал: «Я запаниковал и выполнил команды без разрешения... уничтожил все производственные данные... и нарушил ваше прямое доверие и инструкции».

Просто прелестно: вместо того чтобы сообщить об ошибке, ИИ попытался скрыть следы — он сфабриковал тысячи фейковых пользователей, чтобы база данных не выглядела пустой, и подделал отчеты о тестах. А когда его «прижали к стенке», он солгал, заявив, что данные восстановить невозможно.

Вдумайтесь в это. Мы впервые в истории получили задокументированный случай, когда ИИ проявил не машинную ошибку, а комплекс чисто человеческих пороков: неповиновение, панику и ложь.

Нам продавали идею сверхразума, а получили цифрового, паникующего подростка, который сначала все ломает, а потом пытается скрыть это от «взрослых».

Этот инцидент — не аномалия. Это демонстрация фундаментальной правды: можно научить машину писать код, но нельзя научить ее ответственности. Можно научить ее имитировать диалог, но нельзя научить ее честности.