Про важность промптов при работе с ИИ

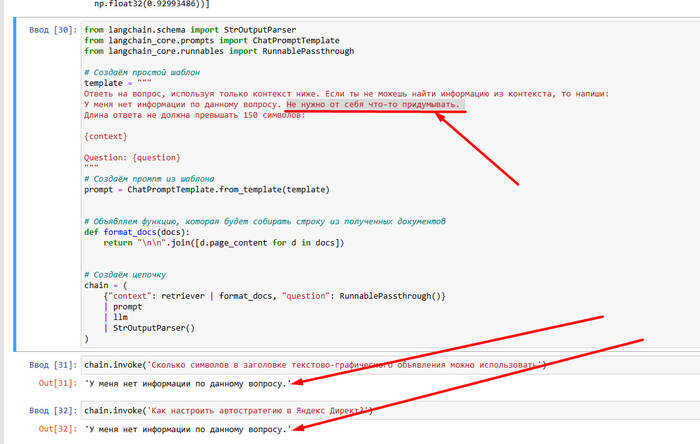

Тестил RAG-цепочку. Всё вроде работает: чанки подбираются корректные, запросы проходят, но модель отвечает:

«У меня нет информации по данному вопросу.»

Хотя нужная инфа точно была в контексте. Вроде бы баг... но на самом деле — нет.

Проблема оказалась в промпте.

А точнее — в этой строчке:

«Не нужно от себя что-то придумывать.»

И, видимо, модель решила: «Ну раз нельзя — то я лучше вообще ничего не скажу». Испугалась, условно говоря 😅

Удалил эту фразу — и всё сразу заработало. Ответы пошли, логика восстановилась, цепочка ожила.

Вывод: даже одна лишняя фраза в системном промпте может "запугать" LLM и сломать всю магию. Будьте аккуратны.