Ожидалось, что ИИ...

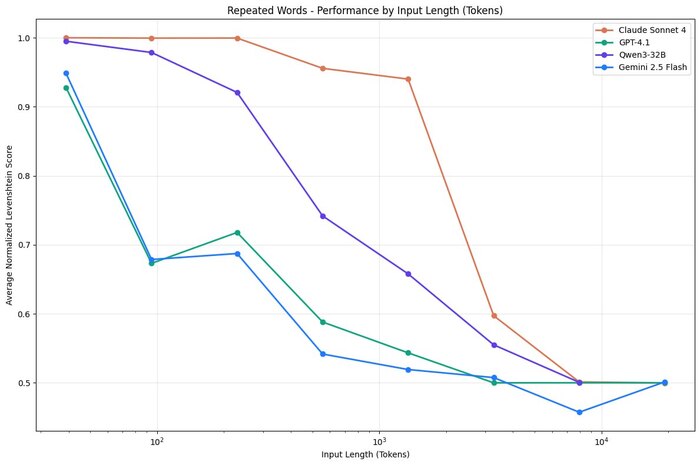

Ожидалось, что ИИ одинаково хорошо справляются с анализом как первых, так и последних токенов в длинных текстах, но на деле производительность падает с ростом длины входа, даже на простых задачах.

Проще говоря, модели “устаете” при большом объёме текста и начинают ошибаться, терять важные данные или путаться. Значит, чтобы такие модели работали хорошо, нужно умело выбирать и структурировать информацию, а не просто кормить их огромными массивами текста без разбора.

В исследовании проверяли 18 моделей, включая GPT-4.1, Claude 4, Gemini 2.5 и Qwen3, и обнаружили, что модели работают всё менее надёжно по мере увеличения длины входного контекста.

Русский ИТ бизнес