Как мы строили ЦОД

Привет, Пикабу!

В каждой крупной компании с обширной IT-инфраструктурой наступает момент, когда разрозненных серверных и кроссовых помещений становится недостаточно, и встаёт вопрос о постройке ЦОДа.

Коснулся этот момент и нас, потому, не откладывая в долгий ящик, приступили к реализации.

Было выбрано помещение подходящей площади и объёма.

Чтобы избежать визита с нашим ЦОДом на этаж ниже, а вес получается немаленький (несколько десятков стоек с оборудованием общим весом более 20 тонн), делаем разгрузочную раму из стального швеллера.

На раме, с большим запасом по высоте, собираем фальшпол. Под ним пойдут коммуникации и воздухообмен системы охлаждения.

Сама система охлаждения тоже не маленькая. Ей предстоит охлаждать оборудование мощностью более 150кВт и поддерживать заданную влажность.

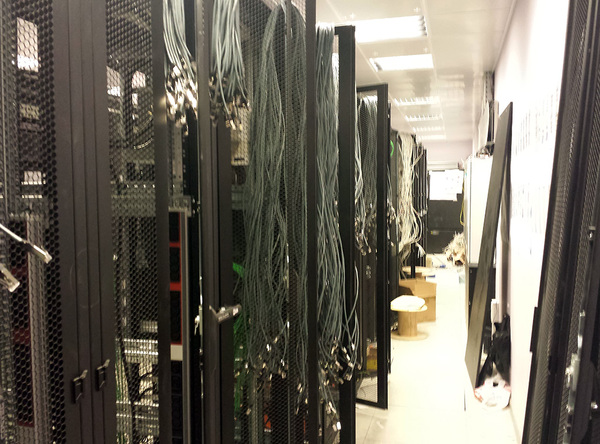

И вот вырисовывается примерный вид будущего ЦОДа. Начинаем прокладывать коммуникации и

монтировать стойки с оборудованием. На весь проект только витой пары ушло несколько десятков километров :)

Здесь, к сожалению, объём работы был такой, что было не до фотографий :(

Поэтому сразу к результату.

Уровень шума в центральном проходе препятствует разговору двух человек на расстоянии более двух метров друг от друга :)

На все работы, от бетонной коробки до ЦОДа, ушло пять месяцев.

На этом всё, спасибо за внимание! :)