Алгоритмы против людей: как умники с Уолл-стрит превратили биржу в казино с кодом

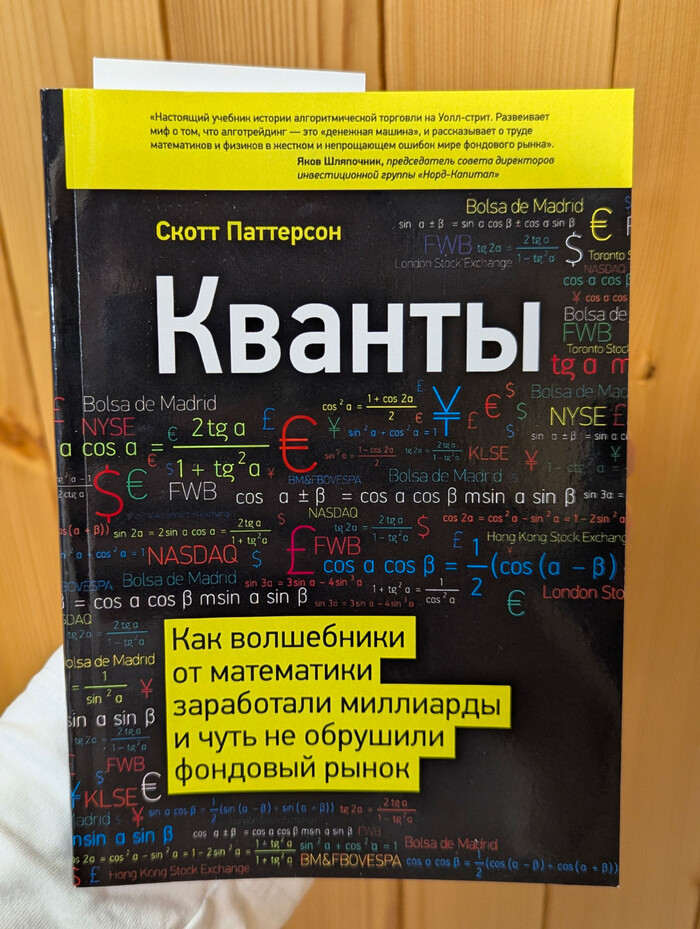

Недавно купил книгу «Кванты. Как волшебники от математики заработали миллиарды и чуть не обрушили фондовый рынок», которую её автор Скотт Паттерсон написал ещё в 2010 году. Книга издана на русском языке в 2014, но я познакомился с ней только недавно и понял что в книге очень хорошо расписана хронология развития алгоритмической торговли и чем она заканчивалась. Спойлер: ничем хорошим в итоге, но в моменте очень выгодно для участников.

Решил сделать статью по мотивам книги — краткую выжимку идей о том, какими алгоритмами и в какое время зарабатывались деньги. Первая часть этой статьи — на основе этой книги, а вторая этой часть — на основе открытых данных из интернета.

Причём странная деталь — заказал книгу на обычном маркетплейсе, но книга шла из‑за рубежа и пришла даже без указания тиража — то есть какая‑то условно китайская копия — раньше с такими не сталкивался.

Ниже первая часть, которая написана на основе этой книги.

Эволюция алгоритмов: как математика захватила Уолл-стрит

История современной финансовой инженерии — это история про то, как математика постепенно вытеснила интуицию. За полвека Уолл‑стрит превратилась в гигантский вычислительный аппарат: биржу, где решения принимают не люди, а алгоритмы. Скотт Паттерсон в книге «Кванты» подробно исследовал этот путь — от простейшего статистического анализа до сложнейших моделей корреляций и высокочастотного трейдинга.

1960-е: от казино к рынку капитала — математический прорыв

Эд Торп - первый квант

Профессор MIT Эдвард Торп стал первым, кто доказал: случайная система подчиняется математике, а значит — её можно обыграть.

Метод: подсчёт карт + критерий Келли (функция максимизации log‑utility)

Критерий Келли решает оптимизационную задачу:

[ \max f(x) = E[\log(1 + xR)] ]

где x — доля капитала в ставке, R — доходность.

Это была первая рабочая модель риск-менеджмента, ставшая фундаментом для последующих моделей портфельной оптимизации.

Переход в финансы: дельта-хеджирование варрантов (1967)

Торп перенёс идеи динамического хеджа в торговлю опционами ещё до публикации формулы Блэка‑Шоулза. Суть алгоритма:

Купить недооценённый варрант.

Продать соответствующую акцию в объёме, равном дельте варранта.

Регулярно обновлять хедж → «реплицировать» поведение опциона.

Фактически это была одна из первых практических реализаций стохастического процесса геометрического броуновского движени и динамического хеджирования.

1970-е: формулы приходят на Уолл-стрит

Метод Блэка‑Шоулза (1973) базируется на предположении:

[ dS_t = \mu S_t dt + \sigma S_t dW_t ]

и отсутствии арбитража.

Формула позволила впервые «правильно» оценивать опционы.

Портфельное страхование (Dynamic Hedging)

Алгоритм превратил репликацию пут‑опциона в массовый продукт. При падении рынка позиции автоматически хеджировались продажей фьючерсов S&P 500.

В реальности дискретная аппроксимация в условиях высокой волатильности привела к положительной обратной связи, что стало катализатором краха 1987 года.

1980-е: статистический арбитраж и рождение машинного подхода

Метод: парный трейдинг

Был основан на утверждении, что разница между двумя «синхронными» акциями — стационарный процесс.

Математическая форма этого:

[ spread_t = y_t — \beta x_t \approx OU\text{‑процесс} ]

Метод: статистический арбитраж

Это масштабирование парной идеи на сотни и тысячи бумаг:

кросс‑секционные регрессии,

ранний PCA,

ранние ML‑подходы (кластеризация).

Группы APT (Morgan Stanley), Renaissance и D.E. Shaw создали первые полноценные алгоритмические машины извлечения альфы.

1990-е: факторные модели и первые элементы машинного обучения

Факторные модели Фама‑Френча

Каждая акция рассматривается как вектор факторных экспозиций.

Цель — построить market‑neutral портфель с экспозицией:

long Value,

long Momentum,

long Size,

short всё остальное.

Клифф Эснесс из AQR превратил это в масштабируемый продукт.

Метод: распознавание образов в ценах (фонд Medallion)

Renaissance применяли методы:

HMM (скрытые марковские модели),

сигнальную обработку,

Kalman Filtering,

wavelet‑декомпозицию,

регрессионные ансамбли.

Это были первые «ML‑прототипы» в торговле.

2000-е: корреляционный риск и кризис

Метод: Gaussian Copula (Дэвид Ли)

Фактором роста CDO было предложение Дэвида Ли использовать статистическую модель «гауссовой копулы» для расчета цен на CDO. В конце 2005 года исследовательская компания Celent оценила размер глобального рынка CDO в $1,5 трлн и прогнозировала, что рынок вырастет ориентировочно до $2 трлн к концу 2006 года.

Модель:

[ C(u, v) = \Phi_\rho(\Phi^{-1}(u), \Phi^{-1}(v)) ]

Главные упрощения этого:

корреляции считаются стабильными,

хвостовые риски срезаются нормальным распределением.

Ошибки копулы стали одной из фундаментальных причин кризиса 2008.

Метод: Credit Arbitrage (Боаз Вайнштейн)

Связь «акций ↔ облигаций ↔ CDS» создаёт сеть относительных цен.

Несогласованности приводят к арбитражу структуры капитала.

Итоги книги

Каждая новая модель давала преимущество — но одновременно увеличивала системные риски. Алгоритмы работали идеально там, где выполнялись их предположения, но терпели катастрофы при нарушении условий рынка.

В книге подчёркивается не злой умысел, а слепая вера в модели. Например, Мэтью Ротман (Goldman) не хотел разрушить рынок — он искренне верил в эффективность рынка и гауссовы распределения, пока реальность не опровергла это.

Книга закончилась, но я попробовал продолжить историю дальше самостоятельно.

Продолжение: квантовая эволюция уже после выхода книги (с 2010 по 2025)

Я немного дописал на основе открытых источников.

2010-е: Big Data и машинное обучение

ML в квантовых фондах. Фонды Two Sigma, D.E. Shaw, Jane Street внедряют:

Random Forest

Gradient Boosting

k-NN

нелинейные факторные модели

Для того чтобы:

обнаруживать микро-паттерны,

классификацировать ордера,

прогнозировать микро-волатильности.

2015–2020: NLP, RL и альтернативные данные

Обработка естественного языка (Natural Language Processing) приходит на рынок. Использование:

Word2Vec

BERT

FinBERT

GPT-like моделей

для оценки тональности новостей, отчётов.

Reinforcement Learning в торговле

Оптимизация инструментов маркет-мейкера и риск-менеджмента через RL:

DQN

PPO

Actor–Critic

Альтернативные данные

Используются даже изображения со спутников, квитанции, поисковые запросы, трафик в торговых центрах.

2020-е: предсказание стакана, трансформеры и микро-структура рынка

Алгоритмические модели микро-структуры (LOB). Для этого используются модели:

LSTM

TCN

Transformer-based time series

Которые решают задачи:

предсказания перехода между состояниями order book,

определения вероятности немедленного движения цены.

Low-latency и FPGA революция

Квантовые фирмы работают на:

FPGA-ускорителях,

специализированных NIC-картах,

colocated-серверах с задержками ~100 нс.

2025+: LLM-Quant эра

Использование LLM в анализе документов. LLM обрабатывают:

отчёты SEC,

корпоративные публикации,

патентные тексты,

судебные материалы.

Роль программиста меняется: создание quant-pipeline, где:

LLM → фичи → ML-модель → торговая стратегия.

Итог

Алготрейдинг уже давно не набор формул. Это инженерная дисциплина, на стыке:

стохастики,

статистики,

ML,

распределённых систем,

сетевой инженерии,

оптимизации под архитектуру (CPU/GPU/FPGA),

больших данных,

системного моделирования.

А рынок — это распределённая вычислительная система, где соревнуются программы.

Автор: Михаил Шардин

🔗 Моя онлайн‑визитка

📢 Telegram «Умный Дом Инвестора»

2 декабря 2025